Cache Memory in Hindi – कैश मेमोरी हिंदी में

Cache Memory Kya Hai? कैश मेमोरी क्या हैं?

कंप्यूटर, परफॉरमेंस और – विशेष रूप से – मेमोरी के बारे में आपकी बातचीत में “कैश” शब्द सामने आया होगा। लेकिन वास्तव में इसका क्या मतलब है और यह मायने क्यों रखता है?

कैश और कैश मेमोरी को समझने से आपको अपने कंप्यूटर को बनाए रखने के लिए सर्वोत्तम विकल्प चुनने में मदद मिल सकती है, ताकि आप कार्यों को अधिकतम दक्षता से कर सकें।

कैश, सरल शब्दों में, डेटा को संग्रहीत करने के लिए उपयोग की जाने वाली मेमोरी के एक ब्लॉक को संदर्भित करता है जिसका दोबारा उपयोग किए जाने की संभावना है। हार्ड ड्राइव और सीपीयू अक्सर कैश का उपयोग करते हैं, ठीक वैसे ही जैसे वेब सर्वर और वेब ब्राउज़र करते हैं। कोई भी कैश कई एंट्रीज से बना होता है, जिसे Pool के रूप में जाना जाता है।

इस गाइड में, आप सीखेंगे कि कैश मेमोरी क्या है और यह आपके दैनिक कंप्यूटर उपयोग को कैसे प्रभावित करती है।

Cache Memory in Hindi – कैश मेमोरी हिंदी में

मेमोरी का एक तेज़ और छोटा सेगमेंट जिसका एक्सेस टाइम रजिस्टरों के जितना करीब होता है उसे कैश मेमोरी के रूप में जाना जाता है। मेमोरी के पदानुक्रम में, कैश मेमोरी का एक्सेस टाइम प्राइमरी मेमोरी से कम होता है। आम तौर पर, कैश मेमोरी बहुत छोटी होती है और इसलिए इसे बफर के रूप में उपयोग किया जाता है।

Cache Memory Kya Hai? कैश मेमोरी क्या हैं?

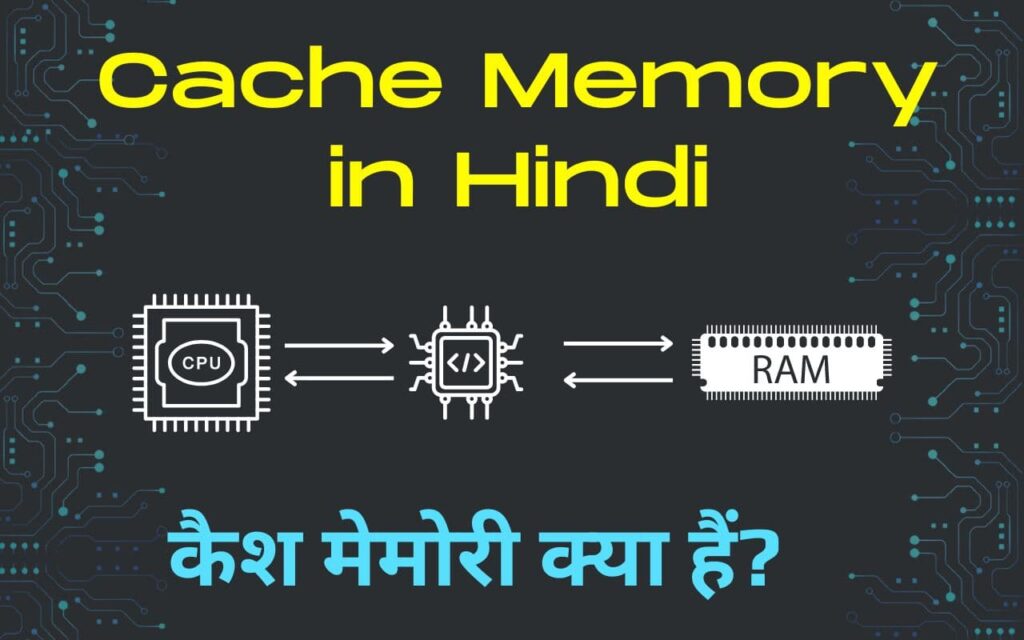

प्राइमरी मेमोरी में डेटा को सेकेंडरी मेमोरी की तुलना में तेजी से एक्सेस किया जा सकता है लेकिन फिर भी, प्राइमरी मेमोरी का एक्सेस टाइम आम तौर पर कुछ माइक्रोसेकंड में होता है, जबकि CPU नैनोसेकंड में ऑपरेशन करने में सक्षम होता है। डेटा को एक्सेस करने और डेटा पर कार्य करने के बीच समय अंतराल के कारण सिस्टम का परफॉरमेंस कम हो जाता है क्योंकि CPU का ठीक से उपयोग नहीं किया जाता है, यह कुछ समय के लिए निष्क्रिय रह सकता है। इस समय अंतराल को कम करने के लिए मेमोरी के नए सेगमेंट को Cache Memory के रूप में जाना जाता है।

यह संदर्भ की स्थानीयता के सिद्धांत पर आधारित है, जो इस अवलोकन को संदर्भित करता है कि प्रोग्राम किसी भी समय उनके एड्रेस स्थान के अपेक्षाकृत छोटे हिस्से को एक्सेस करने की कोशिश करता है, और बार-बार मेमोरी के कुछ हिस्से को एक्सेस करने की कोशिश करता है। उदाहरण के लिए: आपके कॉलेज के फीस विभाग में, बकाया राशि की जांच के लिए अक्सर ट्रांजेक्शन्स का उपयोग किया जाता है।

कैशिंग क्या है?

कैशिंग (अक्सर मेमोरी कैशिंग के रूप में जाना जाता है) एक ऐसी तकनीक है जिसमें कंप्यूटर एप्लिकेशन उस डेटा की तेजी से पुनर्प्राप्ति को सक्षम करने के लिए कंप्यूटर की मुख्य मेमोरी (यानी, रैंडम एक्सेस मेमोरी, या रैम) में डेटा को अस्थायी रूप से संग्रहीत करते हैं। टेम्पररी स्टोरेज के लिए उपयोग की जाने वाली रैम को कैशे के रूप में जाना जाता है।

चूंकि रैम का एक्सेस अन्य मीडिया जैसे हार्ड डिस्क ड्राइव या नेटवर्क को एक्सेस करने की तुलना में काफी तेज है, कैशिंग डेटा तक तेज एक्सेस के कारण एप्लिकेशन्स को तेजी से चलाने में मदद करता है।

कैशिंग विशेष रूप से तब कुशल होती है जब एप्लिकेशन एक सामान्य पैटर्न प्रदर्शित करता है जिसमें वह पहले एक्सेस किए गए डेटा तक बार-बार पहुंचता है। कैशिंग उन डेटा गणनाओं को संग्रहीत करने के लिए भी उपयोगी है जिनकी गणना करने में अन्यथा समय लगता है। गणनाओं को कैश में संग्रहीत करके, सिस्टम गणना की पुनरावृत्ति से बचकर समय बचाता है।

What is Cache Memory in Hindi

कैश मेमोरी का तात्पर्य हाई-स्पीड मेमोरी से है। यह छोटा है लेकिन RAM (मुख्य मेमोरी) से तेज़ है। सीपीयू अपनी प्राइमरी मेमोरी की तुलना में कैश तक तुलनात्मक रूप से अधिक तेजी से एक्सेस कर सकता है। इस प्रकार, हम इसका उपयोग हाई-स्पीड सीपीयू के साथ सिंक्रनाइज़ करने और इसके समग्र परफॉरमेंस को बेहतर बनाने के लिए भी करते हैं।

कैश मेमोरी की भूमिका

Role of Cache Memory in Hindi

कैश मेमोरी की भूमिका नीचे बताई गई है,

कंप्यूटर सिस्टम में कैश मेमोरी एक महत्वपूर्ण भूमिका निभाती है।

- यह तेज़ एक्सेस प्रदान करता है।

- यह सीपीयू और मुख्य मेमोरी (रैम) के बीच बफर का काम करता है।

- इसकी प्राथमिक भूमिका डेटा को एक्सेस करने में लगने वाले औसत समय को कम करना है, जिससे समग्र सिस्टम परफॉरमेंस में सुधार होगा।

कैश मेमोरी के लाभ

Benefits of Cache Memory in Hindi

कैश मेमोरी के विभिन्न लाभ हैं,

- तेज़ एक्सेस: मुख्य मेमोरी से तेज़। यह सीपीयू के करीब रहता है, आमतौर पर एक ही चिप पर या नजदीक में। कैश डेटा और निर्देश के सबसेट को संग्रहीत करता है।

- मेमोरी विलंबता को कम करना: मेमोरी एक्सेस विलंबता का तात्पर्य प्रोसेसेज द्वारा मेमोरी से डेटा पुनर्प्राप्त करने में लगने वाले समय से है। कैश को स्थानीयता के सिद्धांत का फायदा उठाने के लिए डिज़ाइन किया गया है।

- बस ट्रैफिक को कम करना: मुख्य मेमोरी से डेटा को एक्सेस करने में इसे सिस्टम बस पर ट्रांसफर करना शामिल है। बस एक शेयर्ड रिसोस है और अत्यधिक ट्रैफ़िक के कारण भीड़भाड़ हो सकती है और डेटा ट्रांसफर धीमा हो सकता है। कैश मेमोरी का उपयोग करके, प्रोसेसर मुख्य मेमोरी को एक्सेस करने की आवृत्ति को कम कर सकता है जिसके परिणामस्वरूप बस ट्रैफ़िक कम होता है और सिस्टम दक्षता में सुधार होता है।

- प्रभावी सीपीयू उपयोग में वृद्धि: कैश मेमोरी सीपीयू को उच्च प्रभावी गति से संचालित करने की अनुमति देती है। सीपीयू मेमोरी एक्सेस की प्रतीक्षा करने के बजाय निर्देश एक्सीक्यूट करने में अधिक समय व्यतीत कर सकता है। इससे सीपीयू की प्रोसेसिंग क्षमताओं का बेहतर उपयोग होता है और समग्र सिस्टम परफॉरमेंस बेहतर होता है।

- सिस्टम स्केलेबिलिटी को बढ़ाना: कैश मेमोरी समग्र सिस्टम परफॉरमेंस पर मेमोरी विलंबता के प्रभाव को कम करके सिस्टम स्केलेबिलिटी को बेहतर बनाने में मदद करती है।

कैश की कार्यसिस्टम को समझने के लिए हमें कुछ पॉइंटस् को समझना होगा:

- कैश मेमोरी तेज होती है, इन तक बहुत तेजी से एक्सेस किया जा सकता है

- कैश मेमोरी छोटी होती है, बड़ी मात्रा में डेटा संग्रहीत नहीं किया जा सकता है

जब भी सीपीयू को किसी डेटा की आवश्यकता होती है तो वह कैश में संबंधित डेटा की खोज करता है (तेज प्रोसेस) यदि डेटा मिलता है, तो यह निर्देशों के अनुसार डेटा को प्रोसेस करता है, हालांकि, यदि कैश में डेटा नहीं मिलता है तो सीपीयू उस डेटा को प्राइमरी मेमोरी (धीमी प्रोसेस) में खोजता है और इसे कैश में लोड करता है।

यह सुनिश्चित करता है कि बार-बार एक्सेस किया गया डेटा हमेशा कैश में पाया जाता है और इसलिए डेटा को एक्सेस करने के लिए आवश्यक समय कम हो जाता है।

कैश मेमोरी परफॉरमेंस

Performance of Cache Memory in Hindi

- कैश में खोजने पर यदि डेटा मिलता है, तो कैश हिट हो गया है।

- कैश में खोजने पर यदि डेटा नहीं मिलता है, तो कैश मिस हो गया है।

कैश का परफॉरमेंस कैश हिट की संख्या से लेकर खोजों की संख्या तक मापा जाता है। परफॉरमेंस को मापने के इस पैरामीटर को Hit Ratio के रूप में जाना जाता है।

हिट अनुपात (Hit Ratio)=(कैश हिट की संख्या)/(सर्चेज की संख्या)

कंप्यूटर सिस्टम में कैश मेमोरी का उद्देश्य

In a Computer System The Purpose of Cache Memory in Hindi

कैश मेमोरी कंप्यूटर सिस्टम में कई उद्देश्यों को पूरा करती है, सिस्टम के परफॉरमेंस में सुधार करती है और बस ट्रैफिक को कम करती है।

सिस्टम परफॉरमेंस में सुधार

बार-बार एक्सेस किए गए डेटा को कैशिंग करके, कैश मेमोरी प्रोसेसर को सीधे मुख्य मेमोरी को एक्सेस करने की तुलना में इस डेटा तक अधिक तेजी से पहुंचने की अनुमति देती है। इससे डेटा रिट्रीवल समय कम होने से सिस्टम का परफॉरमेंस तेज हो जाता है, साथ ही निर्देशों का तेजी से एक्सीक्यूशन संभव हो जाता है।

कैश का महत्व

कई सॉफ्टवेयर इंजीनियरों का मानना है कि कैशिंग ही चीजों को तेजी से करने का एकमात्र तरीका है। सीधे शब्दों में कहें तो, जब आप महंगा डेटा पुनर्प्राप्त करना चाहते हैं, तो बस इसे कैश करें, ताकि अगली बार जब आप इसे देखें, तो यह कम खर्चीला होगा। आइए समझें क्यों।

1. बेहतर परफॉरमेंस

कैशिंग का प्राथमिक लाभ यह है कि यह सिस्टम के परफॉरमेंस को बढ़ाता है। वेबसाइट फ़ाइल डेटा के कैश्ड संस्करणों को सहेजकर, आपके ब्राउज़र को केवल एक बार कंटेंट डाउनलोड करने होंगे और भविष्य में आने पर फ़ाइलों को पुनः लोड कर सकता है।

2. ऑफ़लाइन एक्सेस

गति बढ़ाने के लिए, एप्लिकेशन पहले और नियमित रूप से उपयोग किए गए डेटा को कैश करते हैं। जैसा कि पहले कहा गया है, यह न केवल चीजों को तेजी से संचालित करता है, बल्कि कुछ परिस्थितियों में, यह एप्लिकेशन को “ऑफ़लाइन” कार्य करने में भी सक्षम बनाता है। उदाहरण के लिए, यदि आपके पास इंटरनेट कनेक्टिविटी नहीं है, तो कोई एप्लिकेशन कैश्ड डेटा का उपयोग करके कार्य करना जारी रख सकता है।

3. ऐप एफिशिएंसी

फ़ाइलों को एक बार डाउनलोड करना बहुत ही कुशल है। किसी फ़ाइल का कैश्ड वर्शन ऐप को दो बार एक्सेस करके समय, बैटरी लाइफ और साथ ही अन्य संपत्तियों को बर्बाद करने से रोकता है। इसके बजाय, एप्लिकेशन को केवल अपडेट या नई जोड़ी गई फ़ाइलें डाउनलोड करने की आवश्यकता है।

4. नेटवर्क एफिशिएंसी

कैशिंग जानकारी का अनुरोध करने और वितरित करने के लिए आवश्यक “यात्राओं” की संख्या को कम करके नेटवर्क बैंडविड्थ के अधिक प्रभावी उपयोग को बढ़ावा देता है। यह प्रभाव इंफ्रास्ट्रक्चर की तैनाती के दोहराव की आवश्यकता को काफी कम कर सकता है, जिसके परिणामस्वरूप पूरे इंटरनेट पारिस्थितिकी तंत्र के लिए काफी लागत बचत और आर्थिक लाभ होंगे। इसके अलावा, कमर्शियल कैशिंग प्रदाता कई ग्राहकों द्वारा शेयर किए गए एनर्जी- एफिसिएंट आईटी इंफ्रास्ट्रक्चर का काफी उपयोग करते हुए बड़े पैमाने पर काम कर सकते हैं।

5. बेहतर क्वालिटी ऑफ सर्विस (QoS)

कैशिंग सर्विसेस की उपलब्धता विकासशील कंटेंट प्रोवाइडर्स (विशेष रूप से नई सर्विसेस की घोषणा करने वाले SMB) के लिए प्रवेश बाधाओं को कम करती है और इन व्यवसायों को नई उपभोक्ता सेवाएं बनाने में सक्षम बनाती है। कैशिंग उभरते और नए कंटेंट प्रोवाइडर्स को महंगे इंफ्रास्ट्रक्चर में निवेश किए बिना उत्पाद/सेवा लॉन्च पर उच्च गुणवत्ता वाली सेवा (QoS) के साथ सकारात्मक यूजर अनुभव प्रदान करने में सक्षम बनाता है, जिससे इन कंपनियों को स्थापित खिलाड़ियों से मुकाबला करने की अनुमति मिलती है।

👉 यह भी पढ़े: BIOS क्या है? अर्थ, प्रकार, कार्य और तथ्य

कैश मेमोरी कहां स्थित होती हैं?

कैश मेमोरी एक छोटी, उच्च गति वाली मेमोरी है जो प्रोसेसर चिप पर या प्रोसेसर और मुख्य मेमोरी के बीच स्थित होती है।

कैश मेमोरी को एक्सेस कैसे करें?

Accessing Cache Memory in Hindi

केवल सीपीयू ही कैश मेमोरी को एक्सेस कर सकता है। यह मेमोरी सीपीयू के बाहर किसी मुख्य मेमोरी/स्टोरेज डिवाइस का आरक्षित हिस्सा हो सकती है। कैश में वह डेटा और प्रोग्राम होते हैं जिनका सीपीयू अक्सर उपयोग करता है। इस प्रकार, यह सुनिश्चित करता है कि जब भी सीपीयू को इस जानकारी की आवश्यकता हो तो जानकारी तुरंत सीपीयू के लिए उपलब्ध हो।

सरल शब्दों में, यदि सीपीयू को सिस्टम की कैश मेमोरी में आवश्यक निर्देश या डेटा मिल जाता है, तो उसे अपनी प्राइमरी मेमोरी या रैम को एक्सेस करने की आवश्यकता नहीं है। इस प्रकार, यह रैम और सीपीयू के बीच बफर के रूप में काम करके सिस्टम के परफॉरमेंस को गति देता है।

मेमोरी कैशिंग कैसे काम करती है?

मेमोरी कैशिंग पहले रैम के एक हिस्से को कैश के रूप में उपयोग करने के लिए अलग रखकर काम करती है। जैसे ही कोई एप्लिकेशन डेटा को पढ़ने का प्रयास करता है, आमतौर पर डेटाबेस जैसे डेटा स्टोरेज सिस्टम से, यह यह देखने के लिए जांच करता है कि वांछित रिकॉर्ड पहले से ही कैश में मौजूद है या नहीं। यदि ऐसा होता है, तो एप्लिकेशन कैश से डेटा पढ़ेगा, इस प्रकार डेटाबेस तक धीमा एक्सेस समाप्त हो जाएगा। यदि वांछित रिकॉर्ड कैश में नहीं है, तो एप्लिकेशन स्रोत से रिकॉर्ड पढ़ता है। जब यह उस डेटा को पुनर्प्राप्त करता है, तो यह डेटा को कैश में भी लिखता है ताकि जब एप्लिकेशन को भविष्य में उसी डेटा की आवश्यकता हो, तो वह इसे कैश से तुरंत प्राप्त कर सके।

चूंकि कैश आकार में सीमित है, अंततः कैश में पहले से मौजूद कुछ डेटा को नए डेटा के लिए जगह बनाने के लिए हटाना होगा जिसे एप्लिकेशन ने हाल ही में एक्सेस किया है। इसका मतलब है कि कैशिंग सिस्टम को एक रणनीति की आवश्यकता है कि जगह बनाने के लिए कौन से रिकॉर्ड हटाए जाएं।

रणनीति एप्लिकेशन के डेटा एक्सेस की प्रकृति पर निर्भर करेगी, और आम तौर पर उन रिकॉर्ड्स को हटाने का प्रयास करेगी जिनके जल्द ही दोबारा एक्सेस होने की उम्मीद नहीं है। उदाहरण के लिए, पिछला हाल ही में उपयोग किया गया – Least-Recently-Used (LRU) रणनीति उस रिकॉर्ड को हटा देगी जिसकी अंतिम एक्सेस कैश में किसी अन्य रिकॉर्ड से पहले थी।

यहां धारणा यह है कि यदि रिकॉर्ड को एक्सेस किए हुए काफी समय हो गया है, तो संभवतः इसे जल्द ही दोबारा एक्सेस नहीं किया जाएगा। या इसे दूसरे तरीके से कहें तो, जो रिकॉर्ड हाल ही में सबसे अधिक उपयोग किए गए थे, उन्हें जल्द ही फिर से उपयोग किए जाने की संभावना है।

पिछला बार-बार उपयोग की जाने वाली – Least-Frequently-Used (LFU) रणनीति में कैश में प्रत्येक रिकॉर्ड की एक्सेस की संख्या को ट्रैक करना और कम से कम एक्सेस वाले रिकॉर्ड को हटाना शामिल है। यहां धारणा यह है कि कभी-कभार उपयोग किए गए रिकॉर्ड का जल्द ही दोबारा उपयोग किए जाने की संभावना नहीं होगी।

कैश के साथ चुनौती यह है कि “कैश मिस” को कैसे कम किया जाए, यानी, उन रिकॉर्ड्स के लिए एप्लिकेशन द्वारा पढ़ने का प्रयास किया जाए जो कैश में नहीं हैं। यदि आपसे बहुत अधिक चूक होती है, तो आपके कैश की एफिशिएंसी कम हो जाती है। एक एप्लिकेशन जो केवल नया डेटा पढ़ता है, उसे कैश से लाभ नहीं होगा, और वास्तव में, कैश की जांच करने के अतिरिक्त काम के बावजूद उसमें वांछित रिकॉर्ड नहीं मिलने के कारण कम परफॉरमेंस प्रदर्शित होगा। बड़े कैश का लाभ उठाकर इस चुनौती को कम करने का एक तरीका है। यह अक्सर एक ही कंप्यूटर पर व्यावहारिक नहीं होता है, यही कारण है कि वितरित (डिस्ट्रिब्यूटेड) कैश उन एप्लिकेशन्स को गति देने के लिए लोकप्रिय विकल्प हैं जिन्हें बड़े डेटा सेट को एक्सेस करने की आवश्यकता होती है। एक डिस्ट्रिब्यूटेड कैश एक क्लस्टर में जुड़े कई कंप्यूटरों की रैम को एक साथ जोड़ता है ताकि आप एक बड़ा कैश बना सकें जो क्लस्टर में अधिक कंप्यूटर जोड़कर बढ़ना जारी रख सके।

कैश की एक और चुनौती “पुराने” डेटा को पढ़ने का जोखिम है, जिसमें कैश में मौजूद डेटा अंतर्निहित स्रोत में लेटेस्ट डेटा को प्रतिबिंबित नहीं करता है। अक्सर यह जोखिम एप्लिकेशन परफॉरमेंस के लिए एक स्वीकार्य समझौता होता है। ऐसे मामलों में जहां ऐसा नहीं है, यह उस एप्लिकेशन पर निर्भर है जो कैश में संबंधित रिकॉर्ड को अपडेट करने के लिए अंतर्निहित डेटा स्रोत को अपडेट करता है।

👉 यह भी पढ़े: Memory Management in OS in Hindi – OS में मेमोरी मैनेजमेंट क्या हैं?

कैश मेमोरी के प्रकार

Types of Cache Memory in Hindi

1. L1 या Level1 कैश:

यह किसी भी कैश मेमोरी के पहले लेवल को संदर्भित करता है, जिसे आमतौर पर L1 Cache या Level 1 कैश के रूप में जाना जाता है। L1 कैश मेमोरी में, CPU के अंदर ही एक बहुत छोटी मेमोरी मौजूद होती है। यदि सीपीयू में चार कोर (एक क्वाड-कोर सीपीयू) होते हैं, तो प्रत्येक कोर का अपना L1 कैश होगा।

चूंकि यह मेमोरी सीपीयू में मौजूद होती है, इसलिए यह सीपीयू के समान ही गति से काम कर सकती है। ऐसी मेमोरी का वास्तविक आकार 2 KB से 64 KB तक होता है। Level1 कैश में दो और प्रकार के कैश होते हैं: इंस्ट्रक्शंस कैश स्टोरिंग, इंस्ट्रक्शंस जो सीपीयू द्वारा आवश्यक होते हैं, डेटा कैश स्टोरिंग के साथ, डेटा जो सीपीयू द्वारा आवश्यक होता है।

2. L2 या Level 2 कैश:

यह कैश L2 कैश या लेवल 2 कैश को संदर्भित करता है। Level 2 कैश किसी दिए गए सीपीयू के अंदर या बाहर दोनों जगह मौजूद हो सकता है। यहां, सीपीयू के सभी कोर अपने अलग (स्वयं) Level 2 कैश से युक्त हो सकते हैं, या वे आपस में एक सिंगल L2 कैश भी शेयर कर सकते हैं। अब, यदि यह सीपीयू के बाहर है, तो यह बहुत तेज़ गति वाली बस का उपयोग करके सीपीयू से जुड़ता है। यहां, कैश की मेमोरी का आकार 256 KB से 512 KB तक होता है। यदि हम गति की बात करें, तो ये Level 1 कैश की तुलना में तुलनात्मक रूप से धीमी हैं।

3. L3 या Level 3 कैश:

इस कैश को L3 कैश या लेवल 3 कैश के रूप में जाना जाता है। यह कैश मेमोरी का तीसरा लेवल है जो सीपीयू के बाहर मौजूद होता है और सीपीयू के सभी कोर द्वारा शेयर किया जाता है। इस प्रकार का कैश सभी प्रोसेसर में मौजूद नहीं होता है। केवल कुछ ही हाई-लेवल प्रोसेसर में इस प्रकार का कैश हो सकता है।

इस प्रकार की मेमोरी सीपीयू के बाहर स्थित होती है। इसे सभी सीपीयू कोर द्वारा भी शेयर किया जाता है। L3 कैश की मेमोरी का आकार 1 से 8 MB तक होता है। हालाँकि L3 कैश L1 कैश और L2 कैश की तुलना में धीमा है, लेकिन यह RAM या रैंडम एक्सेस मेमोरी की तुलना में बहुत तेज़ है।

कैश मेमोरी बनाम रैम

Difference Between RAM and Cache Memory in Hindi

Cache Memory vs RAM

कैश मेमोरी अक्सर उपयोग किए जाने वाले डेटा तक तेजी से एक्सेस प्रदान करने की क्षमता के कारण कंप्यूटर सिस्टम में एक आवश्यक कार्य करती है। प्रोसेसर के करीब स्थित एक हाई-स्पीड स्टोरेज कंपोनेंट के रूप में, कैश मेमोरी प्रोसेसिंग गति और समग्र सिस्टम परफॉरमेंस में काफी सुधार करती है।

यह रैम से बार-बार एक्सेस किए गए डेटा को कॉपी और संग्रहीत करके मुख्य मेमोरी सिस्टम (रैम) के साथ मिलकर काम करता है, जो प्रोसेसर को निर्देशों को एक्सीक्यूट करने के लिए आवश्यक डेटा को बार-बार अनुरोध करने से रोकता है। कैश मेमोरी का प्रभाव कंप्यूटर सिस्टम ऑपरेशन के निम्नलिखित क्षेत्रों में देखा जा सकता है:

- डेटा एक्सेस स्पीड: कैश मेमोरी तेज़ डेटा एक्सेस स्पीड प्रदान करती है, क्योंकि इसका रिस्पॉन्स टाइम रैम की तुलना में बहुत कम होता है।

- बस ट्रैफिक में कमी: रैम को एक्सेस करने के लिए प्रोसेसर की आवश्यकता को कम करके, कैश मेमोरी बस ट्रैफिक और विवाद को कम करती है, जिससे सिस्टम दक्षता बढ़ती है।

- एनर्जी एफिशिएंसी: कैश मेमोरी को एक्सेस करने के लिए रैम को एक्सेस करने की तुलना में कम ऊर्जा की आवश्यकता होती है, जिससे एनर्जी एफिशिएंसी में सुधार होता है और सिस्टम में बिजली की खपत कम होती है।

हालाँकि कैश और रैम दोनों का उपयोग सिस्टम के परफॉरमेंस को बढ़ाने के लिए किया जाता है उनमें बहुत सारे अंतर मौजूद हैं जिनमें वे सिस्टम की दक्षता बढ़ाने के लिए काम करते हैं।

| RAM | Cache |

| कैश की तुलना में RAM आकार में बड़ी होती है। मेमोरी 1 MB से 16 GB तक होती है | कैश आकार में छोटा होता है। मेमोरी आमतौर पर 2KB से लेकर कुछ MB तक होती है। |

| यह उस डेटा को संग्रहीत करता है जिसे वर्तमान में प्रोसेसर द्वारा प्रोसेस किया जाता है। | यह बार-बार एक्सेस किया गया डेटा रखता है। |

| प्राइमरी मेमोरी में डेटा संग्रहीत करने के लिए ओएस सेकंडरी मेमोरी के साथ इंटरैक्ट करता है | कैश में संग्रहीत डेटा प्राप्त करने के लिए रैम ओएस प्राइमरी मेमोरी के साथ इंटरैक्ट करता है। |

| यह सुनिश्चित किया जाता है कि सीपीयू का एक्सेस से पहले रैम में डेटा लोड किया जाए। इससे रैम की कमी कभी खत्म नहीं होती। | सीपीयू कैश में डेटा खोजता है, यदि कैश नहीं मिलता है तो मिस हो जाता है। |

👉 यह भी पढ़े: RAM क्या हैं? रैम के प्रकार, उपयोग, महत्व और आर्किटेक्चर

कैश स्पेस के मैनेजमेंट के लिए रणनीतियाँ

कैश प्रबंधन रणनीतियों का उपयोग यह निर्धारित करने के लिए किया जाता है कि कैश में कौन सा डेटा रखना है और कैश भर जाने पर कौन सा डेटा हटाना है और नए डेटा के लिए जगह बनाने की आवश्यकता है। कैश स्थान के प्रबंधन के लिए कई रणनीतियाँ हैं, जिनमें शामिल हैं:

- पिछला हाल ही में उपयोग किया गया – Least-Recently-Used (LRU): यह रणनीति नए डेटा के लिए जगह बनाने के लिए कैश से उस डेटा को हटा देती है जिसे हाल ही में कम से कम एक्सेस किया गया था। धारणा यह है कि जो डेटा लंबे समय तक एक्सेस नहीं किया गया है, उसके निकट भविष्य में दोबारा एक्सेस किए जाने की संभावना कम है।

- पिछला बार-बार उपयोग किया जाने वाला – Least-Frequently-Used (LFU): यह रणनीति उस डेटा को हटा देती है जिसे कैश से सबसे कम बार एक्सेस किया गया है। विचार यह है कि जो डेटा अक्सर उपयोग नहीं किया जाता है उसका निकट भविष्य में दोबारा उपयोग नहीं किया जाएगा।

- फर्स्ट-इन, फर्स्ट-आउट (FIFO): यह रणनीति नए डेटा के लिए जगह बनाने के लिए पहले कैश में जोड़े गए डेटा को हटा देती है। धारणा यह है कि जो डेटा सबसे लंबे समय तक कैश में रहा है, उसके दोबारा एक्सेस होने की संभावना कम है।

- लास्ट-इन, फ़र्स्ट-आउट (LIFO): यह रणनीति उस डेटा को हटा देती है जिसे नए डेटा के लिए जगह बनाने के लिए हाल ही में कैश में जोड़ा गया था। धारणा यह है कि जो डेटा सबसे हाल ही में जोड़ा गया था, उसके दोबारा एक्सेस होने की संभावना सबसे कम है।

- रैंडम रिप्लेसमेंट: यह रणनीति नई जानकारी के लिए जगह बनाने के लिए रैंडमली कैश से डेटा निकालती है।

कैश प्रबंधन रणनीति का चुनाव कैश किए जा रहे डेटा की प्रकृति और कैश का उपयोग करने वाले एप्लिकेशन की विशेषताओं पर निर्भर करेगा। कुछ प्रकार के डेटा या एप्लिकेशन कुछ रणनीतियों के साथ दूसरों की तुलना में बेहतर काम कर सकते हैं।

कैशिंग के प्रकार

कैशिंग कई प्रकार की होती है, जिनमें शामिल हैं:

- सीपीयू कैश: यह कंप्यूटर की सेंट्रल प्रोसेसिंग यूनिट (CPU) में निर्मित मेमोरी की एक छोटी मात्रा है जो अक्सर एक्सेस किए गए डेटा और निर्देशों को संग्रहीत करती है। सीपीयू कैश सीपीयू के लिए डेटा और निर्देशों का एक्सेसना तेज़ कर देता है, इसलिए उसे धीमी मुख्य मेमोरी या स्टोरेज डिवाइस पर अक्सर नहीं जाना पड़ता है।

- मेमोरी कैश: यह मुख्य मेमोरी (रैम) का एक छोटा सा हिस्सा है जिसे बार-बार एक्सेस किए गए डेटा के लिए टेम्पररी स्टोरेज क्षेत्र के रूप में अलग रखा गया है। मेमोरी कैशिंग हार्ड डिस्क ड्राइव या नेटवर्क जैसे धीमे स्टोरेज मीडिया से डेटा को एक्सेस करने में लगने वाले समय को कम करके एप्लिकेशन्स के परफॉरमेंस को बेहतर बनाने में मदद करता है।

- डिस्क कैश: यह मुख्य मेमोरी (रैम) का एक हिस्सा है जिसका उपयोग उस डेटा को संग्रहीत करने के लिए किया जाता है जिसे हाल ही में डिस्क से पढ़ा या लिखा गया है, जैसे हार्ड डिस्क ड्राइव या सॉलिड-स्टेट ड्राइव। डिस्क कैशिंग डिस्क पर पढ़ने और लिखने के संचालन की संख्या को कम करने में मदद करती है, जिससे सिस्टम के समग्र परफॉरमेंस में सुधार होता है।

- ब्राउज़र कैश: यह वेब कंटेंट, जैसे HTML पेज, इमेजेज और अन्य मीडिया के लिए एक टेम्पररी स्टोरेज क्षेत्र है, जो वेब ब्राउज़र के कैश में संग्रहीत होता है। जब कोई यूजर किसी वेबपेज पर जाता है, तो उनका ब्राउज़र पेज की कंटेंट की एक प्रति कैश में संग्रहीत करता है। जब यूजर उसी वेबपेज पर दोबारा जाता है, तो ब्राउज़र कंटेंट को दोबारा डाउनलोड करने के बजाय कैश से लोड कर सकता है, जिससे पेज के लोडिंग समय में सुधार हो सकता है।

- डिस्ट्रिब्यूटेड कैश: यह एक कैश है जिसे एक नेटवर्क में कई कंप्यूटरों द्वारा शेयर किया जाता है और इसका उपयोग अक्सर एक्सेस किए गए डेटा को संग्रहीत करने के लिए किया जाता है जो कई सर्वरों पर वितरित होता है। कई सर्वरों से डेटा को एक्सेस करने की आवश्यकता को कम करके, वितरित कैशिंग वितरित सिस्टम के परफॉरमेंस में सुधार कर सकती है। वितरित कैशिंग किसी एप्लिकेशन की स्केलेबिलिटी में भी सुधार कर सकती है क्योंकि डेटा को कई स्थानों पर कैश किया जा सकता है, जिसका अर्थ है कि अधिक समवर्ती उपयोगकर्ता कम अनुरोधों के साथ डेटा को एक्सेस सकते हैं।

👉 यह भी पढ़े: कंप्यूटर फंडामेंटल हिंदी में! बेसिक, प्रकार और बहुत कुछ!

कैशिंग और सिस्टम परफॉरमेंस

कैशिंग डेटा और निर्देशों को एक्सेस करने में लगने वाले समय को कम करके कंप्यूटर सिस्टम के समग्र परफॉरमेंस में महत्वपूर्ण योगदान देता है। जब किसी कंप्यूटर प्रोग्राम को डेटा एक्सेस करने की आवश्यकता होती है, तो वह पहले कैश की जांच करता है कि क्या डेटा पहले से ही वहां मौजूद है। यदि ऐसा है, तो प्रोग्राम कैश से डेटा को हार्ड डिस्क ड्राइव या नेटवर्क जैसे धीमे स्टोरेज मीडिया से डेटा को एक्सेस करने की तुलना में बहुत तेजी से एक्सेस कर सकता है। यह प्रोग्राम के एक्सीक्यूशन को गति देता है और सिस्टम के समग्र परफॉरमेंस में सुधार करता है।

कैशिंग व्यक्तिगत प्रोग्राम परफॉरमेंस में सुधार के अलावा, स्लो स्टोरेज डिवाइसेस और नेटवर्क पर कार्यभार को कम करके समग्र सिस्टम परफॉरमेंस में सुधार कर सकता है। सिस्टम कैश में बार-बार एक्सेस किए गए डेटा को संग्रहीत करके, अन्य कार्यों को संभालने के लिए उन्हें मुक्त करके इन डिवाइसेस पर पढ़ने और लिखने के संचालन की संख्या को कम कर सकता है। इसके परिणामस्वरूप बेहतर सिस्टम परफॉरमेंस और प्रतिक्रिया हो सकती है।

कैशिंग डिस्ट्रिब्यूटेडसिस्टम के परफॉरमेंस को भी प्रभावित कर सकता है जो डिस्ट्रिब्यूटेडकैश आर्किटेक्चर जैसे डिस्ट्रिब्यूटेड हैश टेबल (DHT) का उपयोग करता है। कैशिंग इन सिस्टम्स में कई सर्वरों पर वितरित डेटा को एक्सेस करने में लगने वाले समय को कम करने में मदद करती है, जिससे समग्र सिस्टम परफॉरमेंस में सुधार होता है।

कुल मिलाकर, कैशिंग डेटा और निर्देशों को एक्सेस करने में लगने वाले समय को कम करके और धीमी स्टोरेज डिवाइस और नेटवर्क पर कार्यभार को कम करके कंप्यूटर सिस्टम के परफॉरमेंस को बेहतर बनाने के लिए एक महत्वपूर्ण तकनीक है।

उदाहरण उपयोग मामले

1. डेटाबेस एक्सेलरेशन

मेमोरी कैशिंग के लिए एक व्यापक उपयोग का मामला डेटाबेस एप्लिकेशन्स को तेज करना है, विशेष रूप से वे जो कई डेटाबेस पढ़ते हैं। डेटाबेस रीड्स के एक हिस्से को कैश से रीड्स के साथ बदलकर, एप्लिकेशन बार-बार डेटाबेस एक्सेस से उत्पन्न होने वाली विलंबता को हटा सकते हैं। यह उपयोग मामला आम तौर पर ऐसे वातावरण में पाया जाता है जहां बड़ी मात्रा में डेटा एक्सेस देखी जाती है, जैसे कि उच्च ट्रैफ़िक वाली वेब साइट जो डेटाबेस से डायनामिक कंटेंट पेश करती है।

2. क्वेरी एक्सेलरेशन

एक अन्य उपयोग के मामले में क्वेरी एक्सेलरेशन शामिल है, जिसमें डेटाबेस के लिए एक जटिल क्वेरी के परिणाम कैश में संग्रहीत होते हैं। ग्रुपिंग और ऑर्डर जैसे जटिल प्रश्नों को चलाने वाले ऑपरेशन को पूरा होने में काफी समय लग सकता है। यदि क्वेरीज़ को बार-बार चलाया जाता है, जैसा कि कई यूजर्स द्वारा एक्सेस किए गए बिजनेस इंटेलिजेंस (BI) डैशबोर्ड में होता है, तो परिणामों को कैश में संग्रहीत करने से उन डैशबोर्ड में अधिक प्रतिक्रिया सक्षम हो सकेगी।

कैशिंग के साथ सीमाएँ

कैशिंग के संबंध में डेटा दृश्यता सीमा है, जिसका अर्थ है कि यह आपके डेटा के लिए कोई संदर्भ नहीं बनाता है। ऐसा इसलिए है क्योंकि कैश अनिवार्य रूप से स्टोरेज यूनिटस् हैं जिनसे आप डेटा पुनर्प्राप्त कर सकते हैं, इसलिए वे आपके द्वारा संग्रहीत कच्चे डेटा को बाहर निकालने के लिए बिल्कुल सही हैं, लेकिन आपको उस डेटा के लिए कोई बैकग्राउंड देने के लिए नहीं। संभावना है, आपका डेटा अलग-अलग बैकएंड सिस्टम में फैला हुआ है, इसलिए आपको कुछ ऐसी चीज़ की आवश्यकता होगी जो डेटा के विभिन्न रूपों के लिए संदर्भ बना सके, आपको कैश में पहले से संग्रहीत चीज़ों से परे इसे समझने के लिए सहायक जानकारी की आवश्यकता होनी चाहिए।

इसके अलावा, जबकि कैश डेटा तक त्वरित एक्सेस प्रदान करते हैं, वे आपको वास्तविक समय में कैश्ड डेटा से अंतर्दृष्टि प्राप्त करने में सक्षम नहीं बनाते हैं, लगभग उसी समय, जब घटनाएं घटती हैं (यह वह जगह है जहां स्ट्रीम प्रोसेसिंग आती है)। जैसे-जैसे समय बीतता है, आपका डेटा आपके लिए मूल्य खो देता है, क्योंकि डेटा एकत्र करने, इसे संयोजित करने, फिर इसका विश्लेषण करने में समय अंतराल – शायद कैश के अलावा कई अलग-अलग एप्लिकेशन्स का उपयोग करना – मूल्यवान सेकंड खर्च करता है जिनका उपयोग अधिक उत्पादक तरीकों से किया जा सकता है।

दुर्भाग्य से, कैश डेटा में हेरफेर करने, ऑर्गनाइज करने, गणना करने या विश्लेषण करने के लिए पर्याप्त बुद्धिमान नहीं हैं, क्योंकि उनका एकमात्र कार्य संग्रहीत डेटा को पुनः प्राप्त करना है। आपकी कंपनी के लिए इसका मतलब यह है कि कई छूटे हुए राजस्व अवसर हैं जो आपके टेक्नोलॉजी इंफ्रास्ट्रक्चर की दरारों से फिसलते रहते हैं। कैश से एक निश्चित मात्रा में डेटा पुनर्प्राप्त करने और इसे कई अलग-अलग बैकएंड पाइपलाइनों के माध्यम से आगे बढ़ाने में शामिल प्रोसेसिंग समय के कारण आपकी विलंबित प्रतिक्रिया समय, आपको भारी मात्रा में कार्रवाई योग्य जानकारी छोड़ने का कारण बनती है।

सरल कैश पर कंपनी की एकमात्र निर्भरता डेटा की सुव्यवस्थित और एकीकृत प्रस्तुति की कमी की समस्या को जन्म देती है। यह डेटा को एक्सेस करने की कठिन प्रथा के कारण है, जिसे बिखरे हुए, विषम बैकएंड सिस्टम से विभिन्न फॉर्मेटस् और प्रोसेसिंग लैग्वेजेज में संग्रहीत किया जा सकता है। कैश अंतिम यूजर्स और एप्लिकेशन्स तक डेटा कैसे पहुंचाया जाता है इसका कोई स्टैंडर्डडाइज़ेशन नहीं करता। परिणाम: प्रतीत होता है कि डिस्कनेक्ट किया गया और उपयोग में कठिन डेटा। जब आपकी कंपनी के पास डेटा के कई अनूठे स्रोत और डेटाबेस होते हैं, तो उन्नत इनफॉर्मेशन विश्लेषण के लिए सिल्ड डेटा सेट के बीच संबंध स्थापित करना महत्वपूर्ण है।

👉 यह भी पढ़े: Hybrid Computer क्या हैं? हाइब्रिड कंप्यूटर का अल्टीमेट गाइड

कैशिंग का भविष्य

आज के डेटा-संचालित परिदृश्य में, व्यवसायों और उपभोक्ताओं को समान रूप से वास्तविक समय स्ट्रीमिंग डेटा से तत्काल अंतर्दृष्टि की आवश्यकता होती है। केवल बेसिक कैशिंग विधियों पर निर्भर रहने से संगठनों के लिए अवसर चूक सकते हैं।

दूरदर्शी उद्यम पारंपरिक कैशिंग से आगे बढ़ रहे हैं और Hazelcast जैसे प्लेटफ़ॉर्म को अपना रहे हैं। उन्होंने पाया है कि वे दोनों दुनिया के सर्वश्रेष्ठ का उपयोग कर सकते हैं: स्ट्रीमिंग डेटा पर तत्काल अंतर्दृष्टि और कार्यों को सक्षम करते हुए बिजली की तेजी से एप्लिकेशन परफॉरमेंस प्राप्त करने के लिए एक मजबूत स्ट्रीम प्रोसेसिंग इंजन के साथ-साथ एक तेज़ डेटा स्टोर का लाभ उठाना।

Cache Memory in Hindi पर निष्कर्ष:

कैश मेमोरी कंप्यूटर के ऑर्गनाइजेशन और आर्टिटेक्चर में एक आवश्यक भूमिका निभाती है, जो कंप्यूटर के परफॉरमेंस को बेहतर बनाने के लिए अक्सर उपयोग किए जाने वाले डेटा तक त्वरित एक्सेस प्रदान करती है। इसका महत्व प्रोसेसर और मुख्य मेमोरी के बीच एक मौलिक पुल प्रदान करने में निहित है।

👉 यह भी पढ़े: Kernel क्या हैं? परिभाषा, प्रकार और कार्य

कैश मेमोरी क्या हैं? पर अक्सर पूछे जाने वाले प्रश्न

FAQ on What is Cache Memory in Hindi

कैश मेमोरी क्या है? इसका उपयोग क्यों किया जाता है?

कैश अस्थायी मेमोरी को संदर्भित करता है जिसे आधिकारिक तौर पर “सीपीयू कैश मेमोरी” कहा जाता है। कंप्यूटर की यह चिप-आधारित फीचर्स यूजर्स को कुछ डेटा और जानकारी को कंप्यूटर की मुख्य हार्ड ड्राइव से एक्सेस करने की तुलना में तेज़ तरीके से एक्सेस करने देती है। इस प्रकार, कैश मेमोरी इनफॉर्मेशन तक त्वरित एक्सेस में मदद करती है।

कैश मेमोरी के 3 प्रकार कौन से हैं?

कैश के कुल तीन सामान्य लेवल हैं:

L1 कैश, जिसे प्राइमरी कैश के रूप में जाना जाता है, बहुत तेज़ है, लेकिन यह अपेक्षाकृत छोटा है। यह आमतौर पर सीपीयू कैश के रूप में प्रोसेसर चिप में एम्बेडेड होता है।

L2 कैश, जिसे सेकेंडरी कैश के रूप में भी जाना जाता है, अक्सर L1 कैश की तुलना में तुलनात्मक रूप से अधिक क्षमता वाला होता है।

लेवल 3 या L3 कैश एक विशेष मेमोरी को संदर्भित करता है जिसे L1 और L2 के वास्तविक परफॉरमेंस को बेहतर बनाने के लिए विकसित किया गया है।

कैश कैसे काम करते हैं?

कैश में मौजूद जानकारी या डेटा आम तौर पर रैंडम-एक्सेस मेमोरी या रैम जैसे तेज़ एक्सेस हार्डवेयर में संग्रहीत होता है, और यह एक सॉफ़्टवेयर कंपोनेंट के साथ भी हो सकता है। कैश का प्राथमिक उद्देश्य समग्र डेटा पुनर्प्राप्ति परफॉरमेंस को बढ़ाना है। यह बैकग्राउंड में अंतर्निहित स्लो स्टोरेज लेयर को एक्सेस करने के लिए सिस्टम की आवश्यकता को कम करके ऐसा करता है।

सरल शब्दों में कैश क्या है?

कैश, सरल शब्दों में, डेटा को संग्रहीत करने के लिए उपयोग की जाने वाली मेमोरी के एक ब्लॉक को संदर्भित करता है जिसका दोबारा उपयोग किए जाने की संभावना है। हार्ड ड्राइव और सीपीयू अक्सर कैश का उपयोग करते हैं, ठीक वैसे ही जैसे वेब सर्वर और वेब ब्राउज़र करते हैं। कोई भी कैश कई एंट्रीज से बना होता है, जिसे पूल के रूप में जाना जाता है।

कंप्यूटर में कैश मेमोरी क्या है?

कंप्यूटर में कैश मेमोरी एक छोटा, उच्च गति वाला वोलॅटाइल स्टोरेज कंपोनेंट है जो अस्थायी रूप से अक्सर एक्सेस किए गए डेटा और निर्देशों को रखता है। यह डेटा एक्सेस टाइम को काफी कम करके समग्र परफॉरमेंस में सुधार करने के लिए प्रोसेसर और मुख्य मेमोरी (रैम) के बीच काम करता है। अक्सर उपयोग किए जाने वाले डेटा को संग्रहीत करके, कैश मेमोरी प्रोसेसर को अधिक कुशलतापूर्वक और तेज़ी से काम करने की अनुमति देती है। इसके परिणामस्वरूप तेज़ प्रोसेसिंग होती है और यूजर अनुभव बेहतर होता है।

कैश मेमोरी का उपयोग किसमें किया जाता है?

कैश मेमोरी का उपयोग कंप्यूटर सिस्टम की प्रोसेसिंग गति और एफिशिएंसी में सुधार के लिए किया जाता है। यह मुख्य मेमोरी (रैम) से बार-बार एक्सेस किए गए या हाल ही में उपयोग किए गए डेटा को सीपीयू के करीब एक छोटे, तेज़ स्टोरेज क्षेत्र में अस्थायी रूप से संग्रहीत करके करता है। परिणामस्वरूप, सीपीयू इस डेटा को जल्दी से एक्सेस और पुनर्प्राप्त कर सकता है, जिससे मुख्य मेमोरी से डेटा लाने में लगने वाला समय कम हो जाता है। यह अंततः सिस्टम के समग्र परफॉरमेंस और प्रतिक्रियाशीलता को बढ़ाता है।

सीपीयू में कैश मेमोरी क्यों महत्वपूर्ण है?

सीपीयू में कैश मेमोरी महत्वपूर्ण है क्योंकि यह बार-बार एक्सेस किए गए डेटा और निर्देशों को संग्रहीत करती है, जिससे तेजी से पुनर्प्राप्ति और प्रोसेसिंग समय सक्षम होता है। यह कंप्यूटर सिस्टम के समग्र परफॉरमेंस को बढ़ावा देता है। इसके अतिरिक्त, कैश मेमोरी सीपीयू और मुख्य मेमोरी के बीच लगातार कम्युनिकेशन के कारण होने वाली विलंबता को कम करने में मदद करती है, जिससे कार्यों को अधिक कुशलता से पूरा किया जा सकता है। अंततः, कैश मेमोरी विभिन्न कंप्यूटर संचालन को तेज करके यूजर अनुभव को बढ़ाने में महत्वपूर्ण भूमिका निभाती है।

क्या कैश मेमोरी रैम से बेहतर है?

हां, गति और परफॉरमेंस के मामले में कैश आमतौर पर रैम से बेहतर है। कैश मेमोरी को सीपीयू में बनाया गया है, जो रैम की तुलना में अक्सर उपयोग किए जाने वाले डेटा तक तेज़ एक्सेस प्रदान करता है। हालाँकि, कैश मेमोरी रैम की तुलना में आकार में काफी छोटी होती है, जिससे इसमें संग्रहीत डेटा की मात्रा सीमित हो जाती है। परिणामस्वरूप, कैश और रैम कंप्यूटर सिस्टम के समग्र परफॉरमेंस को बढ़ावा देने के लिए एक साथ काम करते हैं।

कैश मेमोरी मुख्य मेमोरी से किस प्रकार भिन्न है?

कैश मेमोरी एक छोटा, उच्च गति वाला स्टोरेज कंपोनेंट है जो अस्थायी रूप से बार-बार एक्सेस किए गए डेटा को संग्रहीत करता है, जबकि मेमोरी (रैम) एक बड़ा, थोड़ा धीमा स्टोरेज क्षेत्र है जिसका उपयोग वर्तमान में चल रहे प्रोग्रामों के लिए डेटा रखने के लिए किया जाता है। कैश आमतौर पर एक प्रोसेसर के भीतर इंटिग्रेट होता है, जिसके परिणामस्वरूप रैम की तुलना में तेज़ एक्सेस टाइम होता है। इसके अलावा, कैश प्रति यूनिट अधिक महंगा है और कई स्तरों (L1, L2, और L3) में ऑर्गनाइज है, जबकि मेमोरी आमतौर पर समरूप होती है और प्रोसेसर से अलग होती है।

अन्य टिप्स जो आपके काम के हैं: